Feedback-Instrument zur Rettungskräfte-Entwicklung - Führungsstab (FIRE-CU)

Das Feedback-Instrument für die Ausbildung von Rettungskräften - Führungsstab (FIRE-CU) erfasst die Qualität der Ausbildung des Führungsstabs der Feuerwehr. Das Instrument basiert auf dem FIRE (Schulte & Thielsch, 2019), einem Instrument zur Bewertung der Ausbildung von Führungskräften der Feuerwehr. Dieses wurde inhaltlich an die Ausbildung von Mitgliedern des Führungsstabs angepasst. Die zusammengestellten Items wurden in einer Studie am Institut der Feuerwehr Nordrhein-Westfalen (IdF NRW) umfassend geprüft. Das Instrument besteht aus 22 Items und erfasst Dozentenverhalten, Anforderungsniveau, Struktur und Gruppe auf Ebene der Lernprozesse sowie die Kompetenzerwerb und Transfer auf Ebene der Lernoutcomes. Eine konfirmatorische Faktorenanalyse konnte diese Struktur bestätigen; die Skalen zeigen eine gute interne Konsistenz und es liegen eindeutige Hinweise auf Konstrukt- und Kriteriumsvalidität vor.

The FIRE-CU is a feedback instrument for the training of rescue forces command staff members. It assesses the quality of the training of the fire brigade command staff. The instrument is based on the FIRE (Schulte & Thielsch, 2019), an instrument for evaluating the training of fire brigade group and platoon leaders. Its content has been adapted to the training of members of the fire department's leadership team. The instrument comprises 22 items and measures behaviour, requirement level, structure and group on the level of learning processes as well as the factors acquisition of competence and transfer on the level of learning outcomes. A confirmatory factor analysis could confirm this structure. The scales show a good internal consistency and there is evidence for convergent, discriminant validity and criterion validity.

https://www.uni-muenster.de/OWMS/bfo/projekte/fire/

Instruktion

Liebe Lehrgangsteilnehmende,

wir schätzen es sehr, dass Sie an unserer Befragung teilnehmen. Indem Sie den Lehrgang hinsichtlich verschiedener Aspekte bewerten, helfen Sie uns, die Qualität der Lehre zu beurteilen und zu verbessern. Bitte kreuzen Sie hierzu bei jeder der folgenden Aussagen das Kästchen an, das den Grad Ihrer Zustimmung am besten beschreibt. Es gibt bei dieser Befragung keine richtigen oder falschen Antworten. Vielmehr interessieren wir uns für Ihre ganz persönliche Meinung.

Bitte beachten Sie:

- Machen Sie hinter jeder Aussage jeweils nur ein Kreuz in einem der dafür vorgesehenen Kästchen (und niemals zwischen oder neben den Kästchen).

- Bitte lassen Sie keine Aussagen aus.

- Wenn eine Aussage für Sie nicht sinnvoll beantwortbar ist, können Sie uns dies durch ein Kreuz in dem entsprechenden Kästchen mitteilen.

Bitte teilen Sie uns hierzu bei den folgenden Aussagen mit, wie sehr Sie diesen zustimmen:

Items

Tabelle 1

FIRE-CU-Items

|

Nr. |

Item |

Subskala |

|

1 |

Die Dozenten fassten schwierige Sachverhalte prägnant zusammen. |

Dozentenverhalten |

|

2 |

Ich finde, die Dozenten gaben nützliches Feedback. |

Dozentenverhalten |

|

3 |

Die Dozenten motivierten mich, mich einzubringen. |

Dozentenverhalten |

|

4 |

Ich finde, die Dozenten waren am Lernerfolg der Teilnehmenden interessiert. |

Dozentenverhalten |

|

5 |

Der Umfang der zu lernenden Inhalte hat mich überfordert. |

Anforderungsniveau |

|

6 |

Das Tempo der Stoffvermittlung war zu hoch für mich. |

Anforderungsniveau |

|

7 |

Die Inhalte der Lehrveranstaltung waren zu schwierig für mich. |

Anforderungsniveau |

|

8 |

Ich finde, die Lehrveranstaltung war klar strukturiert. |

Struktur |

|

9 |

Ich konnte im Verlauf der Lehrveranstaltung die Gliederung immer nachvollziehen. |

Struktur |

|

10 |

Ich finde, die Lehrveranstaltung gab einen guten Überblick über das Themengebiet. |

Struktur |

|

11 |

Die anderen Teilnehmenden brachten sich aktiv ein. |

Gruppe |

|

12 |

Die Teilnehmenden unterstützten sich gegenseitig. |

Gruppe |

|

13 |

Ich finde, es herrschte ein guter Zusammenhalt im Lehrgang. |

Gruppe |

|

14 |

Durch meine Teilnahme an der Lehrveranstaltung habe ich gelernt, die für meine Kolleginnen und Kollegen relevanten Informationen besser zu kommunizieren. |

Kompetenzerwerb |

|

15 |

Durch meine Teilnahme am Lehrgang fällt es mir jetzt leichter, Entscheidungen in kritischen Situationen zu treffen. |

Kompetenzerwerb |

|

16 |

Durch meine Teilnahme am Lehrgang kenne ich meine persönlichen Grenzen besser. |

Kompetenzerwerb |

|

17 |

Durch meine Teilnahme am Lehrgang traue ich mir besser zu, in stressigen Situationen ruhig zu bleiben. |

Kompetenzerwerb |

|

18 |

Durch meine Teilnahme an der Lehrveranstaltung fällt es mir jetzt leichter, von meinen Kolleginnen und Kollegen erhaltene Informationen zu verarbeiten. |

Kompetenzerwerb |

|

19 |

Durch meine Teilnahme an der Lehrveranstaltung kann ich die von meinen Kolleginnen und Kollegen vermittelten Informationen kritisch für meine Aufgaben überprüfen. |

Kompetenzerwerb

|

|

20 |

Ich fühle mich auf meinen nächsten Einsatz, den ich als Stabsmitarbeiter*in durchführen werde, sehr gut vorbereitet. |

Transfer |

|

21 |

Durch die Übungen in den Lehrveranstaltungen habe ich die nötige Sicherheit gewonnen, einen Einsatz als Stabsmitarbeiter*in durchzuführen. |

Transfer |

|

22

|

Ich kann das Gelernte auf meine zukünftige Verwendung im Führungsstab übertragen. |

Transfer |

|

23 |

Ich habe im Lehrgang sehr viel gelernt. |

Globalurteil |

|

24 |

Ich würde dem Lehrgang folgende Schulnote geben: |

Globalurteil |

|

25 |

Ich würde diesen Lehrgang weiterempfehlen. |

Globalurteil |

|

26 |

Anmerkungen für Dozenten (Vorschläge/Lob/Kritik) |

Feedback |

Anmerkung. Alle Items sind positiv gepolt. Items 23 bis 26 sind optional und bilden keine eigenständigen psychometrischen Skalen.

Antwortvorgaben

Item 1-23:

Siebenstufiges Antwortformat mit den Optionen 1 = stimme gar nicht zu, 2 = stimme nicht zu, 3 = stimme eher nicht zu, 4 = neutral, 5 = stimme eher zu, 6 = stimme zu, 7 = stimme vollkommen zu. Ein zusätzliches Feld bietet die Möglichkeit anzugeben, dass das jeweilige Item nicht sinnvoll beantwortbar ist.

Item 24:

Sechsstufiges Antwortformat mit den Optionen 1 = sehr gut, 2 = gut, 3 = befriedigend, 4 = ausreichend, 5 = mangelhaft und 6 = ungenügend.

Item 25:

Dichotomes Antwortformat mit den Optionen ja/nein.

Item 26:

Offenes Antwortformat

Auswertungshinweise

Die FIRE-CU-Items teilen sich in sechs Subskalen auf: Dozentenverhalten, Anforderungsniveau, Struktur, Gruppe, Kompetenzerwerb und Transfer (vgl. Tabelle 1). Items 23 bis 26 (Globalurteil und Feedback) sind optional und gehören nicht zum FIRE-CU-Kernfragebogen, sie können zur allgemeinen Rückmeldung dienen, diese Items sind auch im FIRE (Schulte & Thielsch, 2019) enthalten. Item 23 und 24 orientieren sich an vergleichbaren Items aus etablierten Evaluationsinstrumenten (bspw. FEVOR, Staufenbiel, 2000; KIEL, Gediga et al., 2000; MFE-Sr, Thielsch & Hirschfeld, 2012). Die drei Items zum Globalurteil sollten nicht zu einem Gesamtmaß zusammengefasst werden.

Die Items sind auch in englischer Sprache verfügbar (vgl. Thielsch & Hadzihalilovic, 2020).

Die Auswertung des FIRE-CU erfolgt in mehreren Schritten:

Schritt 1: Punkte für einzelne Antworten vergeben

Für jede Antwort einer Person auf ein Item werden Punkte vergeben. Es wird 1 Punkt vergeben für stimme gar nicht zu, 2 Punkte für stimme nicht zu, 3 Punkte für stimme eher nicht zu, 4 Punkte für neutral, 5 Punkte für stimme eher zu, 6 Punkte für stimme zu und 7 Punkte für stimme vollkommen zu. Bei der Antwort nicht sinnvoll beantwortbar werden keine Punkte vergeben und das betreffende Item wird in der weiteren Auswertung für diese Person ignoriert. Für alle Skalen sind hohe Werte erstrebenswert, ausgenommen die Items der Skala Anforderungsniveau. Bei letzterer sind eher niedrige bis mittlere Werte erstrebenswert, da hohe Werte auf dieser Skala für eine Überforderung der Lehrgangsteilnehmenden sprechen würden. Zur Vereinheitlichung der Rückmeldung können die Angaben auf der Skala Anforderungsniveau negativ kodiert werden (1 Punkt für stimme vollkommen zu, [...], 7 Punkte für stimme gar nicht zu), sodass auf allen Skalen eine positive Evaluation des Lehrgangs mit hohen Punktwerten einhergeht.

Schritt 2: Itemmittelwerte berechnen

In diesem Schritt werden für alle Items die Mittelwerte berechnet, indem die Punkte jedes Items addiert werden (Punktsumme eines Items über alle Antwortenden hinweg) und durch die Anzahl der Lehrgangsteilnehmenden, die auf das jeweilige Item geantwortet haben, dividiert wird. An dieser Stelle ist darauf hinzuweisen, dass die Anzahl der Antworten nicht notwendigerweise der Anzahl der Lehrgangsteilnehmenden entsprechen muss. Dies ist dann der Fall, wenn eine oder mehrere Personen Items als nicht sinnvoll beantwortbar klassifiziert haben. Diese Angaben sind als fehlende Werte zu behandeln. Für eine Online-Befragung empfehlen wir die Items 1-22 als Pflichtfragen vorzugeben. Für eine Papierbefragung empfehlen wir, Personen, die drei Items oder mehr komplett auslassen, aus der Auswertung herauszunehmen. Eine hohe Anzahl von fehlenden Werten bei vielen Personen kann in einer mangelnden Passung des Fragebogens in dem jeweiligen Evaluationskontext begründet sein, hier sollte dann nicht der FIRE-CU sondern ein für den jeweiligen Kontext besser geeignetes Instrument angewendet werden.

Schritt 3: Skalenmittelwerte berechnen

Zur Berechnung der Mittelwerte der einzelnen Skalen des FIRE-CU werden die Mittelwerte der Items auf der betreffenden Skala addiert und durch die Anzahl der Items auf dieser Skala dividiert (siehe auch Tabelle 2).

Tabelle 2

Berechnung der Mittelwerte der 6 FIRE-CU-Skalen des Kernfragebogens

|

Skala |

Itemnummern |

Berechnung des Skalenmittelwerts |

|

Dozentenverhalten |

1, 2, 3, 4 |

|

|

Anforderungsniveau |

5, 6, 7 |

|

|

Struktur |

8, 9, 10 |

|

|

Gruppe |

11, 12, 13 |

|

|

Kompetenzerwerb |

14, 15, 16, 17, 18,19 |

|

|

Transfer |

20, 21, 22 |

|

Anmerkung. ![]() bezeichnet die Itemmittelwerte aus Schritt 2

bezeichnet die Itemmittelwerte aus Schritt 2

Bei den Items der Skala Anforderungsniveau gehen höhere Werte mit höherer Überforderung und damit einer schlechteren Evaluation des Lehrgangs einher. Für die Interpretation durch den Anwendenden kann es hilfreich sein, die numerischen Ergebnisse dieser Skala zu invertieren. Hinsichtlich der Interpretation der Globalurteile (Items Nr. 23-25) sowie des offenen Feedback-Items (Nr. 26) schlagen wir vor, diese lediglich als allgemeine Rückmeldung im Sinne einer Checkliste zu nutzen, beziehungsweise die offenen Anmerkungen erst bei einer hohen Zahl von vergleichbaren Nennungen als handlungsleitend heranzuziehen. Hinsichtlich der Schulnote (Item 24) empfehlen wir statt des Mittelwertes den Median zu bestimmen oder eine Häufigkeitstabelle zu erstellen, da Schulnoten typischerweise Ordinalskalenniveau aufweisen, d.h. nicht gleichabständig sind.

Während die Items 1 bis 22 vollständig vorgegeben werden sollten, sind die Fragen 23 bis 26 optional und können je nach Bedarf eingesetzt oder ausgelassen werden. Eine spezifische Validierung dieser zusätzlichen Items erfolgte nicht, derartige Items sind allerdings in etablierten Evaluationsinstrumenten typisch (vgl. z.B. FEVOR, Staufenbiel, 2000; KIEL, Gediga et al., 2000 oder MFE-Sr, Thielsch & Hirschfeld, 2012).

Generell möchten wir zur Wahrung der Anonymität empfehlen, eine Auswertung erst vorzunehmen, wenn mindestens acht ausgefüllte Fragebögen vorliegen (bzw. bei kleinen Veranstaltungen mit 10 bis 15 Teilnehmenden mindestens 50% an der Befragung teilgenommen haben). Damit ist die sogenannte Anonymitätsschwelle erreicht und einzelne Personen sind nicht mehr zu identifizieren (vgl. Thielsch & Weltzin, 2013). Dementsprechend sollten keine demographischen Variablen erhoben werden, anhand derer Rückschlüsse auf einzelne Personen gezogen werden können.

Schritt 4: Rückmeldung und Nutzung der Ergebnisse

Grundsätzlich sollte der subjektive Charakter einer solchen Evaluation berücksichtigt werden. Ein Feedback aus der FIRE-CU-Evaluation ist für die Dozierenden eine Chance, wichtige Informationen über die eigene Lehrtätigkeit aus Sicht der Veranstaltungsteilnehmenden zu erhalten. Es empfiehlt sich eine Evaluationsbesprechung mit den Befragten abzuhalten, in diesem Rahmen können Ergebnisse des FIRE-CU besprochen und mögliche Missverständnisse geklärt werden. Die Fragebögen eignen sich dabei auch zum Vergleich mit früheren gleichartigen Veranstaltungen oder zwischen verschiedenen Lehrkonzepten. Wenn keine eigenen Vergleichsdaten vorliegen, können die deskriptiven Statistiken in Tabelle 6 (siehe unten) als Orientierung dienen. Von Seiten der verantwortlichen Organisation sollte die Evaluation technisch, aber auch inhaltlich unterstützt werden. Dies umfasst insbesondere Hilfestellungen, sollten Evaluationen wiederholt Verbesserungspotentiale aufzeigen sowie Belobigungen für qualitativ gute Unterrichtstätigkeit.

Anwendungsbereich

Der FIRE-CU ist ein schriftlicher Fragebogen zur Evaluation der Ausbildung von Mitgliedern von Führungsstäben der Feuerwehr ("CU" steht dabei für "Command Unit", vgl. Thielsch & Hadzihalilovic, 2020). Er ist für papierbasierte und digitale Erhebungsformen gleichermaßen geeignet. Sollen parallel zur Stabsausbildung Stabsrahmenübungen evaluiert werden, empfiehlt sich die Verwendung einer angepassten Version des FIRE-E zur Evaluation von Einsatzübungen (vgl. Röseler et al., 2020; Thielsch & Hadzihalilovic, 2020).

Bei der Entwicklung des FIRE-CU wurde darauf geachtet, dass die Items keine rein feuerwehrspezifischen Inhalte erfassen, sondern prinzipiell auch bei Stabsausbildungen in anderen Hochrisikoorganisationen, wie Rettungsdiensten, Polizei und technischen Hilfswerk, eingesetzt werden können. Theoriegeleitet ist davon auszugehen, dass die Qualitätsmerkmale guter Ausbildungen für Krisenstäbe und ähnliche „High Reliability Teams“ in diesen Organisationen vergleichbar sind. Darüber hinaus könnte der FIRE-CU für die Evaluierung von Ausbildungen militärischer Führungsstäbe geeignet sein, da sich die Struktur der Stäbe im Bereich der Feuerwehr aus dieser entwickelt hat. Dabei ist es unabdingbar, die Inhaltsvalidität der Skalen im Hinblick auf die konkret zu evaluierenden Lehrgänge zu beurteilen. Die Anwendung in Bereichen jenseits der Feuerwehr sollte durch eine Validierung der Messungen im neuen Kontext begleitet werden.

Beim FIRE-CU handelt es sich um ein Evaluationsinstrument, bei dem die Bewertung durch die Lehrgangsteilnehmenden am Ende der entsprechenden Ausbildungsmodule erfolgt. Wird der zu evaluierende Lehrgang mit einer Prüfung abgeschlossen, empfiehlt sich die Durchführung der Evaluation am Ende der Ausbildungsphase, aber vor der Prüfung.

Der Führungsstab hat seinen Ursprung im Militär. Er ist definiert als ein beratender und unterstützender Rat, der den Einsatzleiter durch spezifische Rollen, Strukturen und Informationsflüsse unterstützt (Heimann & Hofinger, 2016). Heutzutage sind Führungsstäbe in verschiedenen zivilen Bereichen, wie z.B. bei der Feuerwehr, präsent. Führungsstäbe können als Notfallmanagementteams betrachtet werden, die sich mit Vorfällen befassen, die für lokale Kräfte wie einzelne Feuerwehren oder Rettungsdienste zu groß sind. In ihrer Funktion als operatives Führungsgremium müssen sie Informationen schnell verarbeiten und in kurzer Zeit Entscheidungen treffen (Heath, 1998; Wybo & Kowalski, 1998). In Deutschland besteht der Führungsstab aus erfahrenen Führungskräften der Feuerwehren, die über eine mehrjährige Dienstzeit verfügen und eine spezifische Führungsausbildung absolviert haben (Feuerwehr-Dienstvorschrift (FwDV) 2, 2012; Heimann & Hofinger, 2016). Im Gegensatz zu den unteren Führungsebenen arbeitet der Führungsstab als rückwärtige Führungsunterstützung, d.h. er ist in der Regel nicht am Ort des Geschehens (Lamers, 2016). Da reale Vorfälle in Deutschland bis zur Corona-Krise statistisch im Mittel nur etwa alle 25 Jahre auftraten (es gibt aber lokale Schwankungen, Lamers, 2016), müssen die Stäbe ihre Arbeit regelmäßig in Stabsrahmenübungen trainieren. Damit ein Führungsstab effizient arbeiten kann, werden in Deutschland die Mitglieder des Führungsstabs in Sachgebiete eingeteilt. Diese umfassen die Koordination personeller Aktivitäten, Analyse der Lage, Einsatzplanung und Versorgung sowie optional eigene Sachgebiete für die Presse- und Medienarbeit und für das Informations- und Kommunikationswesen. Um diese Aufgaben in angemessener Weise und mit optimaler Ausführung im Krisenfall zu erfüllen, müssen die Mitglieder des Führungsstabs sehr gut ausgebildet sein. In Deutschland ist Voraussetzung für die Teilnahme an der Führungsstabsausbildung der Feuerwehr eine erfolgreich abgeschlossene Ausbildung für Verbandsführer, d. h. zum Führer großer taktischer Einheiten aus mehreren Zügen. (Lamers, 2016). Damit stellt die Ausbildung für die Arbeit in einem Führungsstab die höchste Stufe der Führungsausbildung der Feuerwehr dar.

Bei einer großen Einsatzlage wird in aller Regel ein gemeinsamer Führungsstab aller nichtpolizeilichen Organisationen (Feuerwehr, Hilfsorganisationen wie das Deutsche Rote Kreuz und das Technische Hilfswerk) auf Ebene der Kreise und kreisfreien Städte gebildet. In den meisten Fällen stellt die Feuerwehr den größten Teil des Personals dieser Führungsstäbe; oft werden nur einzelne Funktionen im Stab von Angehörigen anderer Organisationen wahrgenommen. Zudem tritt in vielen Fällen parallel zum operativ-taktischen Führungsstab ein administrativ-organisatorischer Stab, meist als Verwaltungsstab oder in Nordrhein-Westfalen als Krisenstab bezeichnet, zusammen; beide Stäbe unterstehen dem politisch Gesamtverantwortlichen (Landrat bzw. Oberbürgermeister) und koordinieren ihre Maßnahmen durch Einsatz von Verbindungspersonen. Die vorliegende Datenerhebung beschränkte sich jedoch auf die Ausbildung von künftigen Mitgliedern operativ-taktischer Führungsstäbe.

Ein weiteres wichtiges Merkmal des Führungsstabs stellen gemeinsame mentale Modelle (SMM) aller Teammitglieder dar (Lamers, 2016). Um ein gemeinsames Verständnis für komplexe Situationen während größerer Zwischenfälle zu erzeugen, müssen die Mitglieder des Führungsstabs effizient miteinander kommunizieren (Hagemann, Kluge & Ritzmann, 2012). Sie müssen Informationen kollegial austauschen und verarbeiten (Queck & Gonner, 2016). Diese Kompetenz muss während der Führungsstabsausbildung entwickelt werden.

Wie können die spezifischen Fertigkeiten der Ausbildung bewertet werden und was macht eine gute Ausbildung aus? Evaluationen bieten die Möglichkeit, Informationen über die Angemessenheit der verwendeten Methoden sowie zur Verbesserung der Intervention zu sammeln (Kirkpatrick & Kirkpatrick, 2006). Das von Kirkpatrick (1979) entwickelte Vier-Stufen-Modell ist das am Häufigsten verwendete Modell für Trainingsevaluationskriterien (Arthur, Bennett, Edens & Bell, 2003; Grohmann & Kauffeld, 2013; Passmore & Joao Velez, 2014; Salas & Cannon-Bowers, 2001). Es stellt ein hierarchisches System dar und zeigt die Trainingseffektivität durch vier Kategorien der Bewertung an: Reaktion, Lernen, Verhalten und Ergebnisse (Kirkpatrick, 1979; Passmore & Joao Velez, 2014). Die erste Ebene der Evaluation stellt die Reaktion der Teilnehmenden dar, die die Einstellung und affektive Reaktion der Auszubildenden auf das Training umfasst. Die Bewertung der Reaktion wird anhand der Selbsteinschätzung mittels standardisierter Fragen und schriftlichen Kommentaren unmittelbar nach dem Training operationalisiert (Kirkpatrick & Kirkpatrick, 2006). Es werden affektive und Nutzenfragebögen unterschieden, wobei meta-analytische Befunde nahelegen, dass Nutzenreaktionen eine höhere Korrelation mit Lern- und Verhaltensergebnissen aufweisen als affektive Reaktionsmaße (Alliger, Tannenbaum, Bennett, Traver, & Shotland, 1997). Auf der Ebene des Lernens werden erworbenes Wissen und Handlungskompetenzen der Teilnehmenden erfasst, die wichtige Voraussetzungen für eine Verhaltensveränderung auf Ebene III darstellen. Eine Evaluation auf Verhaltensebene erfasst das Ausmaß, in dem erlernte Trainings- oder Ausbildungsinhalte im Berufsalltag angewandt werden. Da die Anwendung der gelernten Inhalte eine gewisse Anpassungszeit erfordert, kann die Beurteilung der Stufe III nicht unmittelbar nach der Ausbildung erfolgen (Blanchard & Thacker, 2013; Kirkpatrick, 1979). Dasselbe gilt für die Stufe IV, der Ergebnisebene. Die Evaluation auf Ergebnisebene erlaubt eine Untersuchung des Trainings im Hinblick auf Unternehmensziele oder monetäre Größen.

Eine weitere Klassifizierung der Daten zur Trainingsevaluation kann durch die Trennung der Prozess- und Ergebnisebene vorgenommen werden (Blanchard & Thacker, 2013). Die Prozessebene dient der Identifikation von Aspekten des Trainings, die möglicherweise suboptimal abgelaufen sind. Zusätzlich überprüft die Prozessebene die Übereinstimmung des beabsichtigten mit dem tatsächlich implementierten Trainingsprogramm. Dabei erfordern die Prozessdaten einen Auswertungsfokus auf den Dozierenden, die Trainingstechniken und die Lernziele (Blanchard & Thacker, 2013). Die Ergebnisebene liefert wichtige Informationen darüber, ob das Training die beabsichtigten Ziele erreicht hat. Nach Blanchard und Thacker (2013) kann eine alleinige Bewertung der Ergebnisebene die zugrunde liegenden Ursachen nicht eindeutig identifizieren. Daher ist eine Kombination beider Datentypen in einer Trainingsauswertung erstrebenswert.

Unter Berücksichtigung der Literatur scheinen die angewandten Lehrmethoden für die Führungsstabsausbildung im Allgemeinen identisch mit denen zu sein, die in Schulte und Thielsch (2019) für die Ausbildung von Gruppen- und Zugführern beschrieben wurden. Auch Expertengespräche im Rahmen der Skalenentwicklung (siehe unten) zeigten, dass die Lehrmethoden des Trainings vergleichbar sind, während sich die Inhalte aufgrund des unterschiedlichen Publikums unterscheiden. Der FIRE-CU basiert daher auf dem bereits validierten FIRE-Fragebogen und wurde hinsichtlich einzelner Itemformulierungen und der Kompetenzskala angepasst (vgl. Thielsch & Hadzihalilovic, 2020). Der FIRE-CU vereint somit die grundlegenden Eigenschaften des FIRE-Fragebogens und erfasst zusätzlich spezifische Kompetenzen, die Führungsstabsmitglieder während des Trainings erlernen müssen.

Der FIRE-CU wurde im Rahmen eines Kooperationsprojekts der Organisations- und Wirtschaftspsychologie der Westfälischen Wilhelms-Universität Münster mit dem Institut der Feuerwehr NRW (IdF NRW) entwickelt. Im gleichen Kontext sind auch weitere Instrumente für die Evaluation der Führungskräfteausbildung bei der Feuerwehr entstanden (siehe go.wwu.de/fire). Das IdF NRW als zentrale Ausbildungs- und Weiterbildungsstätte für Feuerwehrangehörige und Mitglieder von Krisenstäben des Landes NRW gab im Rahmen einer Neukonzeption der Lehre den Impuls, den FIRE-Fragebogen als Evaluationsinstrument der Gruppen- und Zugführerausbildungslehrgänge zu entwickeln (vgl. Schulte & Thielsch, 2019). Der FIRE-Fragebogen wurde in einem multimodalen Studiendesign anhand von Stichproben entwickelt, die vorwiegend aus Lehrgangsteilnehmenden, aber auch aus Dozenten der Gruppen- oder Zugführerausbildungslehrgänge des IdF NRW bestanden.

Für die Ausbildung von Führungsstäben sollte der FIRE Kernfragebogen (siehe Schulte & Thielsch, 2019; Schulte et al., 2019) angepasst und validiert werden. Am IdF NRW werden jährlich etwa 300 Personen für die operativ-taktische Stabsarbeit ausgebildet. Die Ausbildung umfasste zum Zeitpunkt der Studie einen eintägigen Theorieteil, drei ganztägige Stabrahmenübungen und einen halbtägigen Abschluss mit ergänzenden Unterrichten und einer schriftlichen Abschlussprüfung. Dabei gibt es aus organisatorischen Gründen getrennte Lehrgänge für hauptamtliche (Berufsfeuerwehr) und ehrenamtliche (Freiwillige Feuerwehr) Angehörige der Feuerwehren; beide Lehrgangsarten sind aber inhaltlich nahezu identisch.

Itemkonstruktion und Itemselektion

Der Studie ging ein onlinebasierter Vortest (n = 8) voraus, bei dem die Teilnehmenden eines Ausbildungslehrgangs gebeten wurden, die Anwendbarkeit der angepassten FIRE-Items auf die Führungsstabsausbildung zu beurteilen. Die Items wurden auf einer 7-Punkte-Skala von 1 (= stimme gar nicht zu) bis 7 (= stimme vollkommen zu) bewertet. Ergänzend gab es die Möglichkeit anzugeben, dass das jeweilige Item nicht sinnvoll beantwortbar ist. Zudem zeigte der Vortest, dass Online-Umfragen in diesem spezifischen Feuerwehrkontext eine sehr niedrige Rücklaufquote aufweisen. Daher wurde die weitere Evaluation in Form einer Papier-Bleistift-Umfrage durchgeführt. Zusätzlich wurden Gespräche mit dem Abteilungsleiter und dem stellvertretenden Leiter der Abteilung "Krisenmanagement und Forschung" des IdF NRW zur Überprüfung der Ergebnisse des Vortests genutzt. Auf Grundlage dieser Vortests wurden einige Items ersetzt und angepasst: Dies betrifft die Items 14, 18 und 19 der Skala Kompetenzerwerb, diese wurden auf Basis von van den Bossche et al. (2006) neu geschaffen; zwei Items der ursprünglichen FIRE-Kompetenzskala wurden aufgrund mangelnder Passung zu den Anforderungen an Mitglieder des Führungsstabes weggelassen. Die Items 20 bis 22 der Skala Transfer wurden auf Basis der Experteninterviews angepasst (siehe Thielsch & Hadzihalilovic, 2020). Weiterhin wurden die Items in einer genderneutralen Sprache formuliert.

Itemanalysen

Zur Überprüfung der faktoriellen Struktur wurden konfirmatorische Faktorenanalysen (confirmatory factor analysis, CFAs) durchgeführt. Alle statistischen Analysen wurden mit R (R Core Team, 2018) unter Verwendung der Pakete psych (Revelle, 2018), plyr (Wickham, 2011), lavaan (Rosseel, 2012), ggformula (Kaplan & Pruim, 2018), Hmisc (Harrell, 2018) und mice (van Buuren & Groothuis-Oudshoorn, 2011) berechnet.

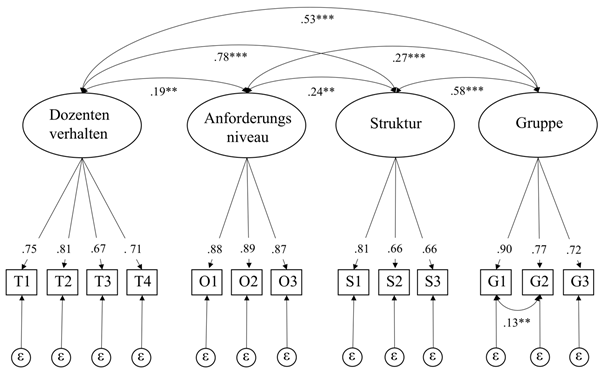

In Anlehnung an die Ergebnisse von Schulte und Thielsch (2019) für den ursprünglichen FIRE-Fragebogen wird auch für den FIRE-CU eine sechsdimensionale Struktur angenommen. So wurde für die Prozessebene des FIRE-CU-Fragebogens eine Vier-Faktoren-Struktur (Dozentenverhalten, Anforderungsniveau, Struktur und Gruppe) erwartet. Diese Struktur findet sich in den Daten mit einer (entsprechend den Konventionen nach Hu und Bentler, 1999) guten Modellanpassung (RMSEA = 0,06 [0,04 - 0,07], SRMR = 0,05, CFI = 0,96, TLI = .95). Nur das χ2 zeigt eine suboptimale Modellanpassung an (χ2(59) = 111,55, p < 0,001), was typischerweise bei großen Stichprobengrößen gefunden wird und daher immer weitere Indizes zur Beurteilung der Anpassung erfordert. Modifikationsindizes dieses Modells deuten auf eine Inter-Item-Korrelation zwischen dem zweiten und dritten Item der Gruppenskala hin, was zu einer leicht verbesserten Modellanpassung führt (χ2(58) = 96,451, p < .01, RMSEA = 0,05 [0,03 - 0,06], SRMR = 0,04, CFI = 0,97, TLI = 0,96). Aufgrund des ähnlichen Inhalts dieser Items erschien eine Korrelation zwischen ihnen angemessen. Wie im Ausgangsmodell ist das χ2 signifikant und weist auf eine suboptimale Modellanpassung hin. Nach Schermelleh-Engel, Moosbrugger und Müller (2003) ist das χ2 in Bezug auf die Freiheitsgrade jedoch akzeptabel (χ2/df = 1,66). Die Ergebnisse der CFA für die Prozessebene finden sich in Abbildung 1.

Abbildung 1. Ergebnisse der CFA für die Prozessskalen; es werden standardisierte Koeffizienten angegeben. *p <.05. **p <.01. ***p < .001.

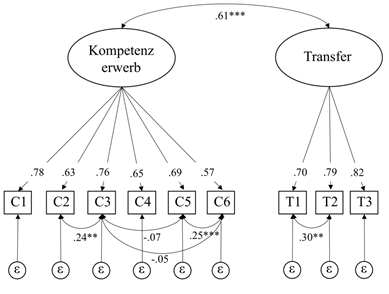

Die postulierte Zwei-Faktoren-Struktur der Ergebnisebene (Kompetenz und Transfer) des FIRE-CU zeigt eine schlechte Anpassung in allen Anpassungsindizes für das Ausgangsmodell (χ2(26) = 140,96, p < .001, RMSEA = 0,12 [0,11 - 0,14], SRMR = 0,07, CFI = 0,87, TLI = 0,82). Bei der Überprüfung der Modifikationsindizes könnten einige wenige Inter-Item-Korrelationen die Modellanpassung verbessern, nämlich die Interkorrelationen zwischen dem ersten und zweiten Item der Transferskala und die Interkorrelationen zwischen dem dritten Item der Kompetenzskala und dem zweiten, fünften und sechsten Item derselben Skala sowie zwischen dem fünften und sechsten Kompetenz Item. Theoretisch sind die Kompetenzen der Führungsstabsmitglieder komplex und voneinander abhängig (Lamers, 2016), daher erscheinen diese Modelländerungen angemessen. Durch Ergänzung dieser Interkorrelationen verbessert sich die Modellanpassung, die so einen guten Fit zeigt χ2(21) = 45,90, p < .01, RMSEA = 0,06 [0,04 - 0,09], SRMR = 0,04, CFI = 0,97, TLI = 0,95]. Die Ergebnisse der CFA für die Ergebnisebene sind in Abbildung 2 abgebildet.

Abbildung 2. Ergebnisse der CFA für die Ergebnisskalen; es werden standardisierte Koeffizienten angegeben. *p < .05. **p < .01. ***p < 001.

Stichproben

Die hier beschriebene Studie fand am IdF NRW statt (vgl. Thielsch & Hadzihalilovic, 2020). Bei den Befragten handelt es sich um Dozierende und Teilnehmende der dortigen Führungsstabs-Lehrgänge. Die Teilnehmenden wurden im Rahmen ihrer Lehrgänge zur Teilnahme aufgefordert und diese wurde nicht vergütet. Die Teilnehmenden wurden gebeten, die Bewertung unmittelbar nach jedem Training anhand eines Papierfragebogens vorzunehmen. Dabei wurde den Teilnehmenden versichert, dass die Bewertung freiwillig und anonym erfolgt. Die Evaluationsphase begann am 2. Juli 2018 und dauerte 16 Wochen, in denen die Dozierenden nach jeder Schulung den Fragebogen unter den Teilnehmenden verteilten und die Teilnehmenden die ausgefüllten Formulare in Umschlägen an sie zurückgaben. In der Umfrage wurden zunächst demographische Daten erhoben, gefolgt von der Stimmungsbewertung der Teilnehmenden. Anschließend wurden die FIRE-CU-Items sowie die Validierungsskalen bewertet. Alle Fragebögen wurden unmittelbar nach der Schulung im Seminarraum ausgefüllt, wodurch eine hohe Rücklaufquote sichergestellt wurde. Die Daten wurden in entsprechenden Seminaren, Kursen und Stabsrahmenübungen gesammelt.

Insgesamt wurde eine Stichprobe von N = 294 Teilnehmenden per Paper & Pencil befragt. Es wurden nur Personen, die die informierte Zustimmung bejahten, in die Analyse einbezogen. Die Fragebögen von sechs Teilnehmenden wurden wegen fehlender Daten aus der Auswertung ausgeschlossen, sodass eine finale Stichprobe von N = 288 resultierte. Insgesamt waren 277 Teilnehmende männlich (96,18%), 9 waren weiblich (2,13%) und zwei Personen gaben kein Geschlecht an (0,69 %). Der hohe Männeranteil entspricht dem in Deutschland vorliegenden Geschlechterverhältnis bei der Feuerwehr (Deutscher Feuerwehrverband, 2019). Die Altersgruppen reichten von 23 bis 64 Jahren (M = 44,00, SD = 8,69). Von den Teilnehmenden waren 30,21 % Berufsfeuerwehrleute, 46,52 % freiwillige Feuerwehrleute, 16,67 % gaben an, sowohl in der Berufs- als auch in der Freiwilligen Feuerwehr tätig zu sein.

Itemkennwerte

Eine Übersicht der Kennwerte der finalen Items findet sich in Tabelle 3.

Tabelle 3

Mittelwerte, Standardabweichungen und Trennschärfen der manifesten Items

|

Item-nummer |

Mittelwert |

Standardabweichung |

Trennschärfe |

Schiefe |

Kurtosis |

Subskala |

|

1 |

5.95 |

0.78 |

0.65 |

-1.03 |

2.60 |

Dozentenverhalten |

|

2 |

6.12 |

0.85 |

0.70 |

-1.34 |

3.33 |

Dozentenverhalten |

|

3 |

5.92 |

0.92 |

0.61 |

-0.97 |

1.31 |

Dozentenverhalten |

|

4 |

6.35 |

0.80 |

0.63 |

-1.65 |

4.12 |

Dozentenverhalten |

|

5 |

2.38 |

1.29 |

0.82 |

1.06 |

0.82 |

Anforderungsniveau |

|

6 |

2.29 |

1.26 |

0.83 |

1.17 |

1.23 |

Anforderungsniveau |

|

7 |

1.98 |

1.00 |

0.81 |

1.24 |

2.15 |

Anforderungsniveau |

|

8 |

6.00 |

0.89 |

0.65 |

-1.25 |

2.35 |

Struktur |

|

9 |

5.78 |

0.96 |

0.59 |

-1.46 |

3.65 |

Struktur |

|

10 |

5.99 |

0.81 |

0.50 |

-1.27 |

3.39 |

Struktur |

|

11 |

6.19 |

0.80 |

0.71 |

-1.20 |

2.77 |

Gruppe |

|

12 |

6.42 |

0.73 |

0.82 |

-1.58 |

4.61 |

Gruppe |

|

13 |

6.48 |

0.76 |

0.78 |

-2.11 |

6.66 |

Gruppe |

|

14 |

5.75 |

0.90 |

0.66 |

-1.02 |

1.61 |

Kompetenzerwerb |

|

15 |

5.38 |

1.16 |

0.63 |

-0.83 |

0.42 |

Kompetenzerwerb |

|

16 |

5.45 |

1.14 |

0.70 |

-1.18 |

1.93 |

Kompetenzerwerb |

|

17 |

5.64 |

0.97 |

0.60 |

-1.11 |

1.99 |

Kompetenzerwerb |

|

18 |

5.47 |

0.94 |

0.65 |

-0.62 |

0.11 |

Kompetenzerwerb |

|

19 |

5.42 |

0.92 |

0.57 |

-0.54 |

-0.11 |

Kompetenzerwerb |

|

20 |

5.44 |

1.13 |

0.76 |

-0.89 |

0.73 |

Transfer |

|

21 |

5.46 |

1.07 |

0.82 |

-0.87 |

1.13 |

Transfer |

|

22 |

5.83 |

0.97 |

0.64 |

-1.20 |

3.24 |

Transfer |

Anmerkung. Skala von 1 = stimme gar nicht zu bis 7 = stimme vollkommen zu. N = 288. Die Zahlen der Subskala Anforderungsniveau beruhen auf invertierten Itemrohwerten. Die Trennschärfen sind um das betreffende Item korrigiert.

Objektivität

Bei der Konstruktion des FIRE-CU wurden keine expliziten Objektivitätskriterien überprüft. Es kann davon ausgegangen werden, dass durch die Standardisierung des Fragebogens, das gebundene Antwortformat und die oben beschriebene Auswertungswertungsmethode und die Angabe von Vergleichsdaten (siehe Deskriptive Statistiken) eine hohe Durchführungs-, Auswertungs- und Interpretationsobjektivität ermöglichen.

Reliabilität

Reliabilitätskoeffizienten für alle FIRE-CU-Skalen sind Tabelle 4 zu entnehmen. Für die Skalen Dozentenverhalten und Gruppe ist Cronbachs α das geeignete Maß, da ein im Wesentlichen τ äquivalentes Messmodell am besten zu den Daten passt. Im Gegensatz dazu zeigen die übrigen Skalen eine bessere Passung für das kongenerische Messmodell, sodass ωH den passenden Koeffizienten darstellt. Die Ergebnisse der χ2-Differenztests sind in den letzten drei Spalten von Tabelle 5 zu finden. Die Reliabilität der Skala Struktur kann als ausreichend beurteilt werden. Gemäß der Reliabilitätsstandards zur Beurteilung der Programmevaluation und des Lernerfolgs (Evers, 2001) weisen alle anderen Skalen eine gute Reliabilität auf. Nach Nunnally (1978) kann die Reliabilität für die Skala Anforderungsniveau als hervorragend bewertet werden.

Tabelle 4

Reliabilitätskoeffizienten und Messmodelltests für die FIRE-CU-Skalen

|

FIRE-CU-Skala |

Cronbachs α |

ωH |

df |

Δχ2 |

p |

|

Dozentenverhalten |

.82 |

.82 |

5 |

12.23 |

.09 |

|

Anforderungsniveau |

.90 |

.91 |

2 |

35.91 |

< .001 |

|

Struktur |

.75 |

.76 |

2 |

17.99 |

< .001 |

|

Gruppe |

.88 |

.88 |

2 |

2.56 |

.28 |

|

Kompetenz |

.85 |

.85 |

14 |

147.18 |

< .001 |

|

Transfer |

.86 |

.87 |

2 |

42.80 |

< .001 |

Anmerkung. Die χ2-Differenzentests vergleichen essentiell tau-äquivalente mit kongenerischen Messmodellen. N = 288.

Validität

Inhaltsvalidität. Die zugrundeliegenden Items des FIRE wurden auf Basis von semistrukturierten Interviews mit Dozenten und Lehrgangsteilnehmenden des IdF NRW ermittelt, zudem wurden die Ursprungsitems von anderen Lehrgangsteilnehmenden im Hinblick auf ihre Vollständigkeit und Relevanz bewertet (vgl. Schulte & Thielsch, 2019; Schulte et al, 2019). Aufgrund dieser Entwicklungsschritte sowie der oben dargestellten Prüfung durch einen Vortest und Expertengespräche wird angenommen, dass die Items das zu messende Konstrukt angemessen repräsentieren und eine inhaltliche Validität gegeben ist.

Konstruktvalidität. Aufgrund mangelnder alternativer publizierter Instrumente, die sich mit der Evaluation der Führungsstabsausbildung befassen, fand die Konstruktvalidierung des FIRE-CU auf Basis the- oretisch verwandter Konstrukte statt. Als konvergente Maße dienten andere Lehrevaluationsinstrumente sowie Biasvariablen zur Überprüfung der divergenten Validität. Biasvariablen sind solche Variablen, die Einfluss auf die Einschätzung der Lehrqualität durch die Urteilenden nehmen, tatsächlich aber nicht mit ihr in Zusammenhang stehen (Spiel, 2001).

Konvergente Validität. Zur Prüfung der konvergenten Validität wurden gut etablierte Skalen für die Lehrevaluation verwendet (vgl. Thielsch & Hadzihalilovic, 2020). Das Dozentenverhalten wurde anhand der Dimension Lehrkompetenz validiert (drei Items, α = .78). Für die Dimension Anforderungsniveau wurde eine gleichnamige Skala verwendet (vier Items, α = .57); beide Skalen wurden aus dem häufig verwendeten und validierten Inventar zur Lehrveranstaltungs-Evaluation HILVE I (Heidelberger Inventar zur Lehrveranstaltungs-Evaluation; Rindermann, 2001) entnommen. Die Dimensionen Struktur und Organisation sowie Kommilitonen (je vier Items) der ersten HILIVE-Auflage (Rindermann & Amelang, 1994) dienten als konvergente Maße für die FIRE-CU-Skalen Struktur und Gruppe. Die Dimension Kompetenz wurde anhand der Skala Fachkompetenz (vier Items, α = .81) der GEKo (Grazer Evaluationsmodell des Kompetenzerwerbs, Paechter, Maier, & Macher, 2011) erhoben. Da keine adäquate Skala für die konvergente Validität der Dimension Transfer vorlag, wurden stattdessen zwei selbstentwickelte Items verwendet: "Die Lehrveranstaltung hat mich gut auf meine kommenden Aufgaben im Führungsstab vorbereitet." und „Durch die Lehrveranstaltung sind mir die Handlungsabläufe im Einsatz klarer geworden.".

Für alle FIRE-CU Skalen zeigen die Korrelationen mit den entsprechenden Skalen große und signifikante Effekte. Die Prozessskalen Dozentenverhalten und Lehrkompetenz (HILVE; Rindermann, 2001) korrelieren mit r = .61 (p < .001), während die Skala Anforderungsniveau und die gleichnamige HILVE-Skala mit r = .57 (p < .001) korrelieren. Die FIRE-CU Skala Struktur und die Items der Struktur und Organisation (HILVE; Rindermann, 2001) zeigen eine Korrelation von r = .50 (p < .001), während Gruppe und Kommilitonen (HILVE; Rindermann, 2001) mit r = .45 (p < .001) korrelieren. Auch die FIRE-CU Ergebnisskalen zeigen eine hohe Korrelation mit den entsprechenden Messgrößen. Selbstbewertungskompetenz und Fachkompetenz (GEKO; Paechter et al., 2011) zeigen eine Korrelation von r = .58 (p < .001), Transfer und die selbst entwickelten Validierungsitems korrelieren mit r = .69 (p < .001).

Tabelle 5 zeigt eine Übersicht der Korrelationen der FIRE-CU-Skalen mit den anderen Evaluationsinstrumenten. Die Ergebnisse unterstützen die Annahme, dass anhand des FIRE-CU die Ausbildungsqualität beurteilt werden kann, da hohe Korrelationen mit den etablierten und validierten Skalen für die Unterrichtsqualität und zusätzlichen konvergenten Maßen aufgezeigt wurden.

Divergente Validität. Zur divergenten Validierung sind im Kontext der Lehrveranstaltungsevaluation Biasvariablen von besonderem Interesse. In diesem Zusammenhang wurde die Stimmung der Teilnehmer anhand einer fünfstufigen Smiley-Skala (Jäger, 2004) erfasst. Jäger (2004) konnte für diese Skala ihre Eindimensionalität und Äquidistanz bestätigen und zeigte hohe Korrelationen mit der deutschen Version der PANAS-Skala (Krohne, Egloff, Kohlmann & Tausch, 1996; .75 £ r £ .89) auf. Eine derartige Biasvariable kann jedoch theoretisch als nicht völlig unabhängig von einzelnen FIRE-CU-Skalen erachtet werden. So ist zu erwarten, dass sich beispielsweise der Lernerfolg positiv auf die Stimmung auswirkt. Kleine oder mittlere Zusammenhänge sprechen daher nicht gegen die Validität der Skalen, wohingegen größere Zusammenhänge die Konstruktvalidität in Frage stellen würden (vgl. Thielsch & Hadzihalilovic, 2020).

Die Korrelationen zwischen der Stimmung der Lehrgangsteilnehmenden und den FIRE-CU Skalen sind signifikant und im kleinen bis mittleren Bereich (0.18 £ r £ 0.32, p < .01). Auch wenn die Korrelationen für einige Items etwas höher sind, sind die Korrelationen mit der Stimmung insgesamt moderat und im Allgemeinen niedriger als die Korrelationen zu konvergenten Maßen. Dieser Befund unterstützt die Annahme, dass die Stimmung die Bewertung der Lehrgangsteilnehmenden nicht entscheidend beeinflusst. Ferner zeigte das Alter der Teilnehmenden weitgehend keinerlei Zusammenhang mit den gegebenen Bewertungen, was als weiterer Indikator für die divergente Validität dient.

Tabelle 5

Validitätsmaße des FIRE-CU

|

Dozentenverhalten |

Anforderungsniveau (r) |

Struktur |

Gruppe |

Kompetenz |

Transfer |

|

Konvergente Maße (grau markiert) |

|

|

|

|

||

|

Lehrkompetenz (H) |

.61*** |

.08 |

.51*** |

.30*** |

.30*** |

.41*** |

|

Anforderungsniveau (H) |

.17** |

.57*** |

.26*** |

.28*** |

.06 |

.34*** |

|

Struktur & Organisation (H) |

.53*** |

.13* |

.50*** |

.27*** |

.26*** |

.34*** |

|

Kommilitonen (H) |

.25*** |

.27*** |

.26*** |

.45*** |

.17** |

.26*** |

|

Dozentenverhalten (G) |

.49*** |

.09 |

.49*** |

.36*** |

.58*** |

.50*** |

|

Transfer (eigen) |

.48*** |

.19** |

.49*** |

.40*** |

.57*** |

.69*** |

|

Divergente Maße |

|

|

|

|

|

|

|

Stimmung |

.31*** |

.32*** |

.25*** |

.29*** |

.18** |

.31*** |

|

Alter |

.09 |

.06 |

.09 |

.03 |

.01 |

.24*** |

|

Simultane Maße |

|

|

|

|

|

|

|

Note (r) |

.45*** |

.19** |

.42*** |

.33*** |

.28*** |

.44*** |

|

Gesamtzufriedenheit |

.44*** |

.19** |

.44*** |

.39*** |

.31*** |

.48*** |

Anmerkung. N = 288. Lehrkompetenz (H) = Lehrkompetenz (HILVE Skala); Anforderungsniveau (H) = Anforderungsniveau (HILVE Skala); Struktur & Organisation (H) = Struktur und Organisation (HILVE Skala); Kommilitonen (H) = Kommilitonen (HILVE Skala); Dozentenverhalten (G) = Fachkompetenz (GEKo Skala); Stabsrahmenübung (eigen) = Stabsrahmenübung (eigen); r = negativ kodiert; Note wurde von 1 = sehr gut bis 6 = ungenügend bewertet, wird aber zur Veranschaulichung in dieser Tabelle umgekehrt kodiert; p < .10. *p < .05. **p < .01. ***p < .001.

Kriteriumsvalidität. In der vorliegenden Studie wurden die Konstrukte zur Überprüfung der Kriteriumsvalidität gleichzeitig mit den Hauptskalen erhoben und repräsentiert daher die konkurrente Validität. Für den FIRE-CU wurden meist mittlere Korrelationen (entsprechend den Konventionen von Cohen, 1992) gefunden. Theoriegeleitet sollten hohe Werte auf den verschiedenen FIRE-CU-Dimensionen mit einer hohen Gesamtzufriedenheit der Teilnehmenden mit dem Lehrgang einhergehen. Zur Validierung benutzten wir daher eine Gruppe von fünf Items (Schulte & Thielsch, 2019; Staufenbiel, 2000; Thielsch & Hirschfeld, 2012), welche die Gesamtzufriedenheit mit dem Lehrgang erfragten. Die Gesamtzufriedenheit reicht von r = 0.19 (p < .01) für die Skala Anforderungsniveau bis r = 0.44 (p < .001) für die Skala Dozentenverhalten. Darüber hinaus wurden die Teilnehmenden gebeten, den jeweiligen Ausbildungskurs anhand einer Schulnote zu bewerten (1 = sehr gut bis 6 = ungenügend, für die Auswertung zur Veranschaulichung umgekehrt kodiert). Diese wurden ebenfalls als Indikatoren für konkurrente Validität verwendet und reichen von r = 0.19 (p < .01) für die Skala Anforderungsniveau bis r = 0.45 (p < .001) für die Skala Dozentenverhalten. Insgesamt zeigen die Indikatoren für die konkurrente Validität moderate bis hohe Korrelationen und legen daher eine gültige Bewertung der Zielkriterien unter Verwendung des FIRE-CU nahe.

Deskriptive Statistiken

Tabelle 6 zeigt einen Überblick der deskriptiven Statistiken der einzelnen Subskalen.

Tabelle 6

Mittelwerte, Standardabweichungen, Kurtosis und Schiefe der Subskalen

|

Skala |

M |

SD |

Kurtosis |

Schiefe |

|

Dozentenverhalten |

6.09 |

.68 |

4.25 |

-1.27 |

|

Anforderungsniveau |

5.78 |

1.09 |

.92 |

-.99 |

|

Struktur |

5.92 |

.73 |

2.71 |

-1.11 |

|

Gruppe |

6.36 |

.69 |

5.89 |

-1.74 |

|

Kompetenz |

5.52 |

.76 |

.53 |

-.67 |

|

Transfer |

5.58 |

.93 |

1.95 |

-.98 |

Anmerkung. Die Beantwortung der Items erfolgte mit einem 7-stufigen Antwortformat mit 1 = stimme gar nicht zu bis 7 = stimme vollkommen zu. N = 288.

Nebengütekriterien

Die FIRE-CU-Skalen erlauben eine sehr zeit- und kostenökonomische Erfassung der Teilnehmendenurteile über die Qualität der Ausbildungen von Mitgliedern von Führungsstäben im Rettungsdienst. Die Durchführungsdauer darf mit etwa 4 bis 5 Minuten (Schätzwert der Autoren) als zumutbar sowohl für Dozierende als auch für Teilnehmende gelten. Es besteht die mit der Verwendung von Rating-/Likertskalen stets einhergehende Möglichkeit zur Verfälschung der Antworten. Um die Motivation zum ehrlichen Antworten zu erhöhen, sollte den Teilnehmenden in jedem Falle Anonymität zugesichert werden (vgl. Auswertungshinweise sowie Thielsch & Hadzihalilovic, 2020).

Weiterführende Literatur

Thielsch, M. T., Busjan, J. N., & Frerichs, K. (2018). Feedback-Instrument-zur Rettungskräfte Entwicklung – Prüfungen (FIRE-P) [Feedback instrument for rescue force development – examinations (FIRE-P)]. Zusammenstellung sozialwissenschaftlicher Items und Skalen (ZIS). https://doi.org/10.6102/zis260

Thielsch, M. T. & Hadzihalilovic, D. (2020). Evaluation of Fire Service Command Unit Trainings. International Journal of Disaster Risk Science, 11(3), 300-315. https://doi.org/10.1007/s13753-020-00279-6

Danksagung

Diese Arbeit wurde vom Institut der Feuerwehr NRW (IdF NRW) mit nicht-monetären Mitteln unterstützt. Die Autoren danken insbesondere Patrick Fuchs und Yannick Ngatchou vom IdF NRW für ihre umfassenden Support während des Evaluationsprojekts. Darüber hinaus danken wir Guido Hertel (Universität Münster) für sein wertvolles Feedback zur Studie.